O

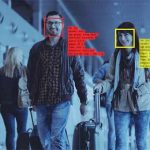

verheden en bedrijven houden bij hoe wij ons leven leiden met een unieke marker die de meesten van ons niet kunnen verbergen of veranderen: ons eigen gezicht. Overal in het land komen gemeenschappen in het geweer met wetten die deze gevaarlijke technologie aan banden leggen.

In reactie hierop beweren sommige regeringen en bedrijven dat deze wetten alleen zouden moeten gelden voor bepaalde vormen van gezichtsherkenning, zoals gezichtsidentificatie, en niet voor andere, zoals het clusteren van gezichten, schrijft EFF.org.

Wij zijn het daar niet mee eens. Alle vormen van gezichtsherkenning zijn een bedreiging voor de privacy, de vrijheid van meningsuiting en raciale rechtvaardigheid. In dit artikel wordt ingegaan op de verschillende vormen van gezichtsherkenning en wordt uitgelegd waarom ze allemaal bij wet moeten worden geregeld.

Wat is gezichtsherkenning?

Op het meest basale niveau neemt gezichtsherkenningstechnologie beelden van menselijke gezichten en probeert daar informatie uit te halen over de mensen die erin staan.

Zo werkt het tegenwoordig meestal:

Eerst wordt de afbeelding automatisch verwerkt om te bepalen wat wel en wat geen gezicht is. Dit wordt vaak “gezichtsdetectie” genoemd. Dit is een eerste vereiste voor alle meer gesofisticeerde vormen van gezichtsherkenning die we hieronder bespreken. Op zich is gezichtsherkenning niet noodzakelijk schadelijk voor de privacy van de gebruiker. Er zijn echter aanzienlijke raciale verschillen in veel gezichtsherkenningstechnologieën.

Vervolgens extraheert het systeem kenmerken uit elk beeld van een gezicht. De ruwe beeldgegevens worden verwerkt tot een kleinere reeks getallen die de onderscheidende kenmerken van een gezicht samenvatten. Dit wordt vaak een “gezichtsafdruk” genoemd.

Gezichtsafdrukken, in plaats van ruwe gezichtsbeelden, kunnen worden gebruikt voor alle hieronder beschreven verontrustende taken. Een computer kan de gezichtsafdruk van twee afzonderlijke beelden vergelijken om te proberen te bepalen of het om dezelfde persoon gaat. Hij kan ook andere kenmerken (zoals geslacht en emotie) van de persoon uit de gezichtsafdruk proberen te raden.

Gezichtsmatching

De meest gebruikte vorm van gezichtsherkenning wordt vaak “gezichtsmatching” genoemd. Het probeert twee of meer gezichtsafdrukken te matchen om te bepalen of ze dezelfde persoon zijn.

Elk gezichtsherkenningssysteem dat wordt gebruikt voor “traceren”, “clusteren”, of “verificatie” van een onbekende persoon kan gemakkelijk worden gebruikt voor “identificatie”

Gezichtsherkenning kan worden gebruikt om foto’s van onbekende personen te koppelen aan hun werkelijke identiteit. Dit wordt vaak gedaan door een gezichtsafdruk te nemen van een nieuwe foto (bv. genomen door een bewakingscamera) en deze te vergelijken met een database van “bekende” gezichtsafdrukken (bv. een overheidsdatabase van ID-foto’s). Indien de onbekende gezichtsafdruk voldoende gelijkenis vertoont met een van de bekende gezichtsafdrukken, geeft het systeem een mogelijke overeenkomst aan. Dit wordt vaak “gezichtsidentificatie” genoemd.

Gezichtsidentificatie kan ook worden gebruikt om na te gaan of twee gezichtsafdrukken van hetzelfde gezicht zijn, zonder noodzakelijkerwijs te weten van wie dat gezicht is. Een telefoon kan bijvoorbeeld het gezicht van een gebruiker controleren om te bepalen of hij moet ontgrendelen, vaak “gezichtsverificatie” genoemd.

Ook kan een sociale-mediasite de foto’s van een gebruiker scannen om te bepalen hoeveel unieke personen erop staan, zonder die personen bij naam te noemen, vaak “gezichtsclustering” genoemd. Deze techniek kan worden gebruikt voor één-op-één-matches (zijn twee foto’s van dezelfde persoon?), één-op-veel-matches (komt deze referentiefoto overeen met één van een reeks foto’s?), of veel-op-veel-matches (hoeveel unieke gezichten zijn er in een reeks foto’s?). Zelfs zonder gezichten aan namen te koppelen, kan “face matching” worden gebruikt om de bewegingen van een persoon in real time te volgen, bijvoorbeeld in een winkel of in een stad, vaak “face tracking” genoemd.

Zelfs als technologie voor gezichtsidentificatie nooit wordt gebruikt, kunnen technologieën voor het clusteren en traceren van gezichten een bedreiging vormen voor de privacy, de vrijheid van meningsuiting en de gelijkheid. De politie kan bijvoorbeeld gezichtsherkenningstechnologie gebruiken om een onbekende demonstrant te volgen van een demonstratie naar zijn huis of auto, en hem vervolgens identificeren met een adres- of kentekengegevensbank. Of de politie kan gezichtsclusteringstechnologie gebruiken om een reeks van meerdere foto’s van een bepaalde niet-geïdentificeerde demonstrant te maken, en de demonstrant handmatig identificeren door die reeks te vergelijken met een databank van politiefoto’s, terwijl een dergelijke handmatige identificatie onmogelijk zou zijn geweest op basis van een enkele foto van de demonstrant.

Nauwkeurigheid, fouten en vooringenomenheid

In 2019 werd Nijeer Parks ten onrechte gearresteerd nadat hij verkeerd was geïdentificeerd door een gezichtsherkenningssysteem. Ondanks het feit dat hij 300 kilometer verwijderd was van de plaats van het vermeende misdrijf, zat Parks 10 dagen in de gevangenis voordat de politie hun fout toegaf.

Nijeer Parks is minstens de derde persoon die ten onrechte is gearresteerd als gevolg van foutieve gezichtsherkenningstechnologie. Het is geen toeval dat alle drie de personen zwarte mannen waren. Gezichtsherkenning is nooit perfect, maar het is alarmerend meer foutgevoelig wanneer het wordt toegepast op iedereen die geen blanke en cisgender man is. In een baanbrekende studie uit 2018 toonden Joy Buolamwini en Dr. Timnit Gebru aan dat gezichtsidentificatiesystemen vrouwen van kleur meer dan 40 keer zo verkeerd identificeerden als blanke mannen. Meer recent bevestigden NIST-tests van verschillende state-of-the-art gezichtsherkenningssystemen een brede, dramatische trend van ongelijke “vals-positieve” percentages tussen demografische groepen, met hogere foutpercentages voor gezichten die niet blank en mannelijk waren.

Bovendien zijn gezichtsherkenningssystemen die misschien beter presteren bij laboratoriumbenchmarks – bijvoorbeeld bij het identificeren van goed verlichte portretfoto’s – in de echte wereld meestal veel minder nauwkeurig. Wanneer dezelfde technologie een meer realistische taak krijgt, zoals het identificeren van mensen die door een instappoort van een luchthaven lopen, presteert zij veel minder goed.

Om vele redenen is een wijdverspreide toepassing van gezichtsherkenning – zelfs als die nauwkeurig en onbevooroordeeld zou zijn – onverenigbaar met een vrije samenleving. Maar de technologie van vandaag is verre van accuraat, en ze is sterk bevooroordeeld op manieren die het racisme uitvergroten.

Wij verwachten dat onderzoekers bij het volgen en clusteren van gezichten dezelfde soort onaanvaardbare fouten en vooringenomenheid zullen aantreffen als reeds bij de identificatie van gezichten zijn aangetroffen. Dit is een reden te meer waarom privacywetten alle vormen van gezichtsherkenning moeten aanpakken.

Een andere vorm van gezichtsherkenning: Gezichtsanalyse

Gezichtsherkenning heeft veel meer toepassingen dan het matchen van een gezichtsafdruk met een andere. Het wordt ook gebruikt om te proberen iemands demografische kenmerken, emotionele toestand en meer, te raden op basis van zijn gelaatstrekken. Een ontluikende industrie maakt gebruik van wat vaak “gezichtsanalyse” of “gezichtsinferentie” wordt genoemd om te trachten dit soort hulpinformatie te extraheren uit live of opgenomen beelden van gezichten. Gezichtsanalyse kan worden gebruikt in combinatie met andere technologieën, zoals eye tracking, om de gezichtsreactie op datgene waarnaar men kijkt te onderzoeken.

Demografische analyse

beweren dat zij gezichtsherkenningstechnologieën kunnen gebruiken om demografische attributen aan hun doelwitten toe te wijzen, waaronder geslacht, ras, etniciteit, seksuele geaardheid en leeftijd.

Het is twijfelachtig of een dergelijke demografische gezichtsanalyse ooit echt kan “werken”. Zij berust op de veronderstelling dat verschillen in de structuur van een gezicht een perfecte afspiegeling zijn van demografische kenmerken, terwijl dat in veel gevallen niet waar is. Deze demografische kenmerken zijn vaak sociale constructies en veel mensen passen niet netjes onder maatschappelijke etiketten.

Wanneer het wel “werkt”, althans volgens degene die het toepast, kan demografische gezichtsidentificatietechnologie uiterst gevaarlijk zijn voor gemarginaliseerde groepen. Deze systemen stellen marketeers bijvoorbeeld in staat mensen te discrimineren op basis van geslacht of ras. Winkels zouden kunnen proberen met behulp van gezichtsanalyse niet-geïdentificeerde klanten te sturen in de richting van verschillende goederen en kortingen op basis van hun geslacht of emotionele toestand – een misplaatste poging, of die nu slaagt of mislukt. In het afschuwelijkste geval kan automatische demografische gevolgtrekking helpen bij het automatiseren van genocide.

Deze technologieën kunnen mensen ook schaden door niet te werken. Genderherkenning” bijvoorbeeld zal iedereen die niet de traditionele geslachtskenmerken vertoont, verkeerd identificeren en kan schadelijk zijn voor transseksuelen, niet-binaire personen, personen die geen geslachtsverandering vertonen en intersekse personen. Daarom voeren sommige activisten campagne om geautomatiseerde herkenning van geslacht en seksuele geaardheid te verbieden.

Emotie-analyse

Gezichtsanalyse kan naar verluidt ook de emoties of “affecten” van een persoon identificeren, zowel in real time als op historische beelden. Verschillende bedrijven verkopen diensten waarvan zij beweren dat zij aan de hand van het gezicht kunnen bepalen hoe iemand zich voelt.

Deze technologie is pseudowetenschap: in het beste geval kan ze leren enkele culturele normen te identificeren. Maar mensen drukken hun emoties vaak verschillend uit, afhankelijk van cultuur, temperament en neurodivergentie. Proberen een universele mapping te ontdekken van “gezichtsuitdrukking” naar “emotie” is een sluipjacht. Het onderzoeksinstituut AI Now noemde het gebrek aan wetenschappelijke basis en het potentieel voor discriminerend misbruik van deze technologie in een vernietigend rapport uit 2019, en riep regelgevers op het gebruik ervan te verbieden voor belangrijke beslissingen over mensenlevens.

Nog verontrustender is het feit dat deze systemen kunnen worden gebruikt voor “pre-crime”-politie, waarbij computergestuurde gissingen over de geestelijke toestand worden gebruikt om mensen die niets hebben misdaan, onder de loep te nemen. Het Amerikaanse ministerie van Binnenlandse Veiligheid heeft bijvoorbeeld miljoenen uitgegeven aan een project met de naam “FAST”, waarbij onder meer gebruik wordt gemaakt van gezichtsidentificatie om “kwade opzet” en “bedrog” te detecteren bij mensen op luchthavens en aan de grens. Gezichtsanalyse kan ook worden verwerkt in zogenaamde “agressiedetectoren”, die zogenaamd kunnen voorspellen wanneer iemand op het punt staat gewelddadig te worden. Deze systemen zijn uiterst bevooroordeeld en bij lange na niet betrouwbaar, maar zullen waarschijnlijk worden gebruikt om buitensporig geweld of onrechtmatige detentie te rechtvaardigen tegen wie volgens het systeem “boos” of “bedrieglijk” is. Het gebruik van algoritmen om mensen te identificeren voor detentie of disciplinair onderzoek is uiterst riskant en zal veel meer de bestaande vooroordelen versterken dan iemand veiliger maken.

Sommige onderzoekers zijn zelfs zo ver gegaan te suggereren dat “criminaliteit” kan worden voorspeld aan de hand van iemands gezicht. Dit is duidelijk niet waar. Dergelijke technologie zou de grotere problemen met voorspellend politiewerk op onaanvaardbare wijze verergeren.

Actie ondernemen

Om de risico’s van de vele vormen van gezichtsherkenning te beperken, moet ieder van ons de eindbeslisser zijn over hoe onze biometrische gegevens worden verzameld, gebruikt of gedeeld.

Om uzelf en uw gemeenschap te beschermen tegen het ongeoorloofd verzamelen van biometrische gegevens door bedrijven, kunt u contact opnemen met uw vertegenwoordigers en hen vertellen zich aan te sluiten bij de senatoren Jeff Merkley en Bernie Sanders in hun pleidooi voor een nationale wet op de privacy van biometrische informatie.

Het gebruik van gezichtsherkenningstechnologie door de overheid is een nog grotere bedreiging voor onze essentiële vrijheden. Daarom moeten overheidsinstanties stoppen met deze praktijk, punt uit. Meer dan een dozijn gemeentes van San Francisco tot Boston hebben al actie ondernomen door hun lokale instanties te verbieden deze technologie te gebruiken.

Om te weten te komen hoe u vandaag nog stappen kunt ondernemen om een einde te maken aan het gebruik van gezichtsherkenningstechnologie door de overheid in uw omgeving, bezoekt u EFF’s About Face resource page.

Voor een voorgestelde taxonomie van de verschillende vormen van gezichtsherkenning die in dit bericht worden besproken, zie deze lijst van veelgebruikte termen.